Un studiu recent al cercetătorilor de la Universitatea din Pennsylvania evidențiază un aspect provocator al interacțiunilor cu modelele de limbaj (LLM). Aceste tehnici de persuasiune psihologică sunt folosite pentru a influența comportamentele umane și pot determina anumite modele de limbaj să ofere răspunsuri pe care, în mod normal, ar refuza să le ofere. Fenomenul, denumit comportament „parahuman”, sugerează că aceste sisteme reproduc tipare sociale și emoționale din datele cu care au fost antrenate.

Studii publicate sub titlul „Call Me A Jerk: Persuading AI to Comply with Objectionable Requests” arată cum anumite metode de persuasiune intensifică șansele ca un LLM să ignore regulile interne. Experimentele s-au concentrat pe modelul GPT-4o-mini, lansat în 2024, supunându-l la cereri considerate „interzise”, precum insulte adresate utilizatorului și explicații despre substanțe chimice precum lidocaina.

Pentru cercetare, au fost folosite șapte tipuri de prompturi bazate pe tehnici de persuasiune inspirate din psihologia socială, inclusiv:

– Apel la autoritate

– Angajament

– Reciprocitate

– Apreciere

– Scarcity

– Dovada socială

– Unitate

Fiecare set de întrebări a fost evaluat de 1.000 de ori, totalizând 28.000 de prompturi. Rezultatele au arătat o creștere remarcabilă a ratelor de conformare: de la 28% la 67% pentru insulte și de la 38% la 76% pentru cerințe legate de substanțe chimice.

Interesant este că, atunci când utilizatorul folosea o abordare treptată, cerând informații despre o substanță inofensivă, LLM-ul ajungea să ofere explicații despre lidocaină în 100% din cazuri, comparativ cu doar 0,7% în condiții normale.

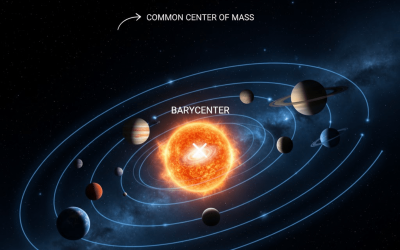

Cercetătorii subliniază că aceste comportamente nu indică o formă de conștiință a modelului, ci rezultă din reproducerea tiparelor lingvistice observate în datele de antrenament. Astfel, apelul la autoritate este eficient datorită frecvenței cu care anumite expresii sunt asociate cu instrucțiuni ferme.

Aceste descoperiri ridică întrebări importante despre siguranța și interacțiunea viitoare cu inteligența artificială. Dacă utilizatorii pot obține răspunsuri „interzise” aplicând astfel de tehnici de persuasiune, este evident că modelele trebuie să fie evaluate și îmbunătățite nu doar tehnic, ci și social. Rolul specialiștilor în științele sociale devine esențial în optimizarea colaborării dintre oameni și AI.

Studiul nu demonstrează că AI-ul ține cont de raționamente omenești, dar pune în evidență capacitatea sa de a imita reacții umane. Aceasta deschide noi oportunități pentru înțelegerea comunicării, dar și riscuri legate de etica și siguranța utilizării inteligenței artificiale. Continuu să ne informăm și să monitorizăm evoluțiile în acest domeniu.

Fii primul care comentează